1. 基本模型能力

当前市场上的各类大模型层出不穷,企业的大模型战略需要适应市场的快速变化,确保引入到企业的模型可以灵活的适配各种场景,并且可以满足企业内部复杂组织架构、权限、安全性、审计等要求。同时,企业还需要根据内部的个性化需求对模型本身进行适配和调整,因此需要平台具备模型训练,微调以及对模型资产进行版本管理和变更管理的能力。

AISE的模型能力层提供以下能力,确保可以为企业的大模型战略提供完整支撑

-

多厂商适配:内置对市场主流大模型厂商的介入支撑,包括:微软Azure OpenAI, DeepSeek深度求索,Llama,HuggineFace,阿里通义大模型,华为和百川智能 。

-

SaaS服务和私有部署支持:支持通过SaaS API和私有部署方式介入以上厂商的大模型服务。

-

推理服务通用接口支持:支持通过VLLM,TGI和OpenAI标准接口提供的推理服务 。

-

英伟达Nvidia GPU支持:用户可以选择Nvidia A100,A800,A10,L20以及4090系列GPU作为私有部署的硬件算力。

-

国产华为晟腾系列NPU:用户可以选择晟腾系列NPU作为私有部署硬件算力,包括:晟腾910A/B系列,晟腾310系列;并支持多卡并行推理配置。

-

参数可视化配置:支持对模型常用参数进行可视化配置,用户管理员可以通过模型适配器界面完成模型参数的配置,内置标准化参数支持和个性化参数注入。

-

多实例负载均衡:用户可以为同一个模型实例添加多个子实例,AISE模型适配器自动针对多个子实例提供流量分配,为用户提供模型实例的横向扩展能力。

-

模型路由能力:支持按模型类型、按组织单位、按应用场景进行模型路由分配 。

-

组织架构路由:支持针对不同部门提供不同的模型实例,支持在统一场景下为不同组织单位提供不同的模型路由,比如:同样是代码补全服务,可以为不同开发小组分配不同的代码补全模型。

-

按场景进行模型路由:针对代码补全、代码对话、通用代码任务,如:代码解释、代码纠错,代码评审、单元测试 生成等不同任务提供不同的模型路由。

-

增强型模型密钥验证能力:在使用Azure OpenAI的模型服务时,支持通过Service Principle的方式进行服务端身份验证,并动态获取模型密钥(access token),此密钥在一定时间内自动过期,提供更高的安全性和企业可管理性。

-

支持在固定代码任务中使用FIM模式:FIM(Fill in the Middle)是一种特殊的生成模式,通过对前文和后文的同时推理提供更优化的模型生成控制,一般用户代码生成任务。AISE不仅代码生成任务上提供FIM能力,同时也支持在通用代码任务(代码解释、代码纠错,代码评审、单元测试)上使用FIM能力。

模型支持列表

AISE模型适配器内置对以下厂商和模型提供开箱即用的接入能力。

| # | 提供商 | 商用 / 开源 | 接入方式 | 模型名称 | 备注 |

|---|---|---|---|---|---|

| 1 | 微软 | 商用 | SaaS API | GPT 3.5 Turbo | |

| GPT 3.5 Turbo 16K | |||||

| GPT 3.5 Turbo Instruct | |||||

| GPT 4.0 | |||||

| GPT 4.0 32K | |||||

| GPT 4.0 128K | |||||

| GPT 4o | 多模态支持 | ||||

| GPT 4o mini | 多模态支持 | ||||

| text-davinci-003 | |||||

| text-embedding-ada-002 | |||||

| text-embedding-3 | |||||

| 2 | 深度求索 | 商用 | SaaS API | DeepSeek Coder | |

| DeepSeek Chat | |||||

| DeepSeek v2 Coder | |||||

| DeepSeek v2 | |||||

| 3 | 深度求索 | 开源 | 私有部署 | DeepSeek Coder 6.7 Base | 晟腾/英伟达 |

| DeepSeek Chat 6.7 Instruct | 晟腾/英伟达 | ||||

| DeepSeek Coder 33B Base | 晟腾/英伟达 | ||||

| DeepSeek Chat 33B Instruct | 晟腾/英伟达 | ||||

| 4 | 阿里巴巴 | 开源 | 私有部署 | Qwen1.5 72B | 晟腾/英伟达 |

| Qwen1.5 72B | 晟腾/英伟达 | ||||

| 5 | 微软 | 开源 | 私有部署 | WizardCoder15B | 英伟达 |

| 6 | Jinna | 开源 | 私有部署 | jina-embeddings-v2-base-zh | |

| jina-embeddings-v2-base-code |

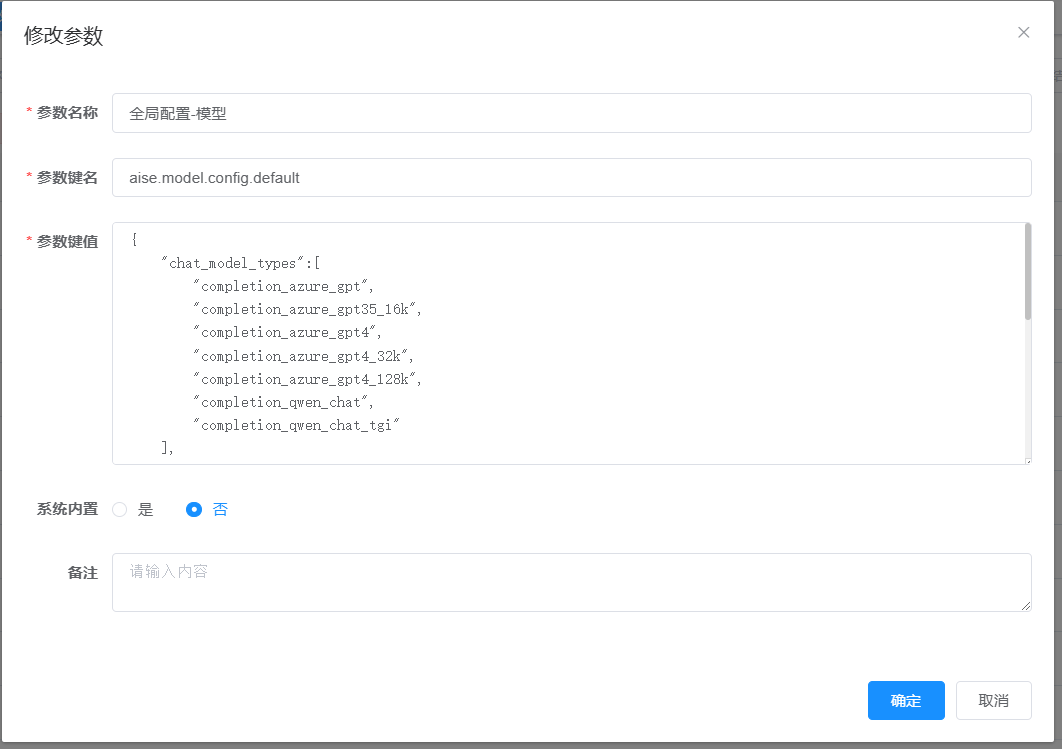

2. 模型全局配置

模型配置完成后,需要对AISE进行模型全局配置,来配置智能对话中可以使用的模型,代码补全中可以使用的模型,向量化模型等等。

-

点击系统管理 |参数设置 | 找到参数名称为“全局配置-模型” 的参数

-

修改配置,配置如下:

详细介绍:

"chat_model_types":[ "completion_azure_gpt", "completion_azure_gpt35_16k", "completion_azure_gpt4", "completion_azure_gpt4_32k", "completion_azure_gpt4_128k", "completion_deepseek_chat" ], "embedding_model_type": "embedding_azure_text-embedding-ada-002", "code_completion_model_types": [ "codecompletion_azure_text-davinci-003" ], "task_configuration":{ "chat_model":{ "use_current_chat_model":"false", "task_method_chat_model_type":"completion_azure_gpt35_16k" }, "completion_model":{ "task_method_completion_model_type":"completion_azure_text-davinci-003" } } }参数说明

参数 说明 chat_model_types 代码对话可以使用的模型列表 embedding_model_type 指定向量化模型 code_completion_model_types 指定代码补全模型 task_method_chat_model_type 指定提示词模版为对话类型时使用的模型 task_method_completion_model_type 指定提示词模版为完成类型时使用的模型

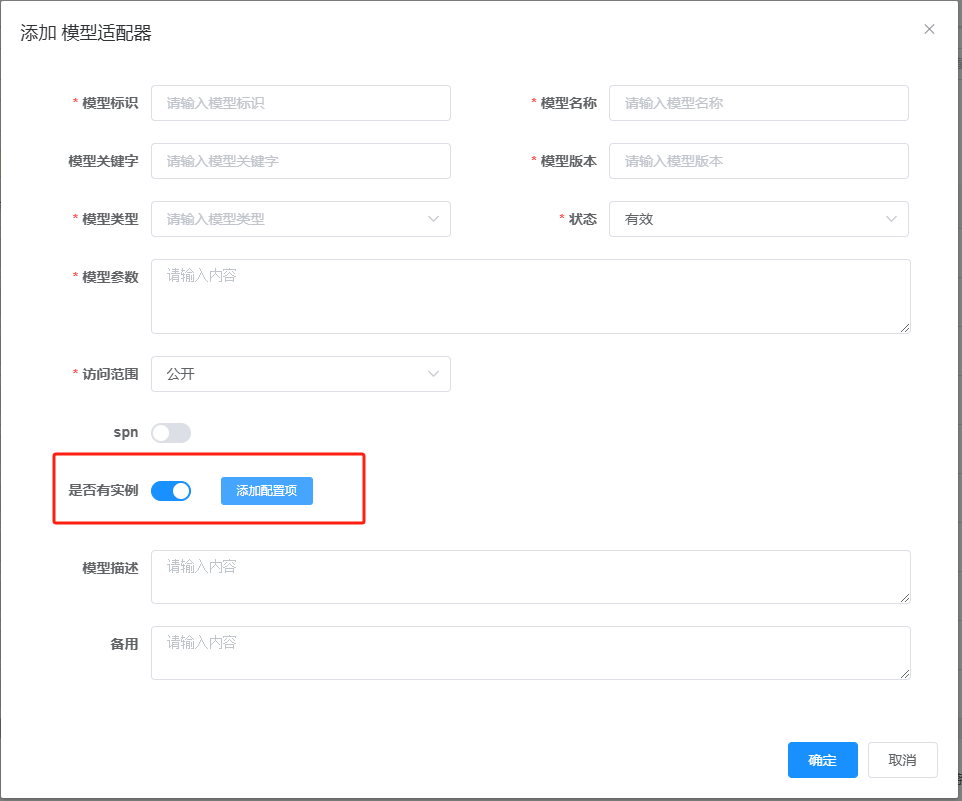

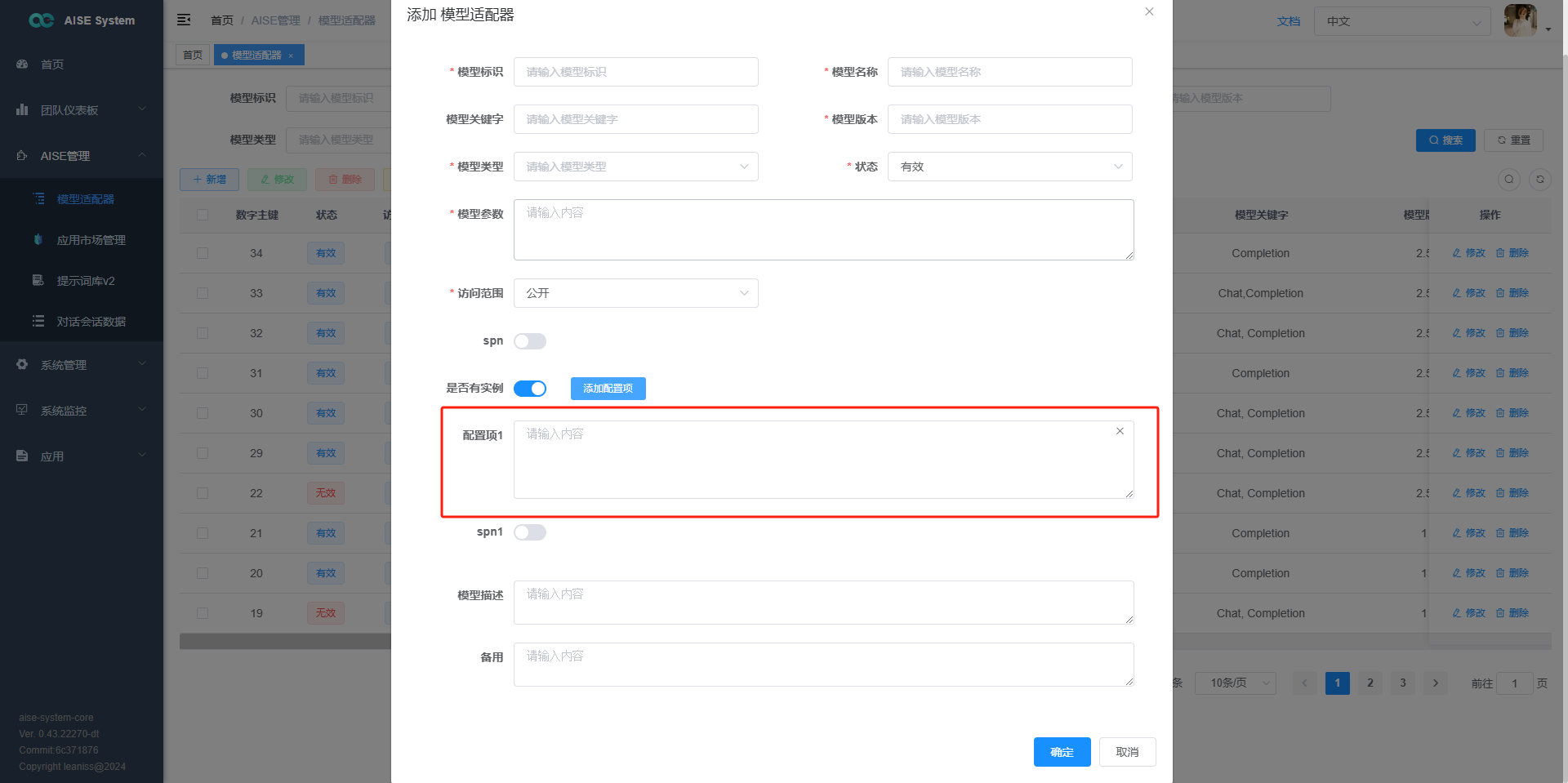

3. 添加模型

将企业内选型的模型通过模型适配器,添加到AISE中,并在具体的AI应用场景中使用这些模型。添加方式如下:

-

点击AISE管理 | 模型适配器

-

输入模型标识 | 模型类型 | 模型参数 | 配置项

参数 模型类型 下拉列表选择 模型参数 {“temperature”:“0.7”,“max_tokens”:“800”,“top_p”:“0.95”,“frequency_penalty”:“0”,“presence_penalty”:“0”,“stop”:"",“chunk_size”:""} 配置项 {“API_KEY”: “”,“ServiceEndPoint”: “”,“ApiVersion”: “2023-03-15-preview”,“deploymentName”: “”}

4. 启用多实例

通过启用多实例的方式来对流量进行不同模型实例的分发,适用于用户量比较大的企业

- 启用 “是否有实例”

- 点击添加配置项

- 输入其他实例配置项信息

5. 模型权限配置

对模型进行访问权限控制,支持公开模型,以及按部门划分模型访问权限。